Michael Corey y Don Sullivan son ejecutivos TI con mucha experiencia en base de datos y sus métodos de protección. Corey es el presidente de Ntirety, una división de HOSTING; MVP de Microsoft SQL Server, VMware vExpert y ex presidente del Grupo de Usuarios Independientes de Oracle.

Don Sullivan, por su parte, ha estado en VMware desde 2010 y es el gerente de Marketing de línea de productos para aplicaciones críticas para el negocio. La experiencia de ambos les faculta para analizar y hacer ciertas recomendaciones para preservar sistemas TI.

Y es que para estos dos expertos no son necesarias muchas razones para insistir en la importancia de resguardar los sistemas tecnológicos, más aún si incluyen datos privados de millones de usuarios.

Sólo le basta referir la suspensión de vuelos de United por un problema informático, la interrupción del servicio de NYSE por culpa de la actualización del software o la renuncia de Katherine Archuleta, directora de la OPM, luego de una violación masiva de datos del personal, para entender las graves consecuencias de no estar completamente preparados ante un desastre cibernético.

En las compañías, a juicio de los expertos, no solamente se deben enfocar en las preocupaciones financieras sino en la revisión externa y periódica de la salud de sus bases de datos.

Muchas de las organizaciones que se han enfrentado a desastres en la red se han conformado con verlos como daños colaterales, pero Corey y Sullivan han dejado claro que ha sido producto de sus acciones e inacciones.

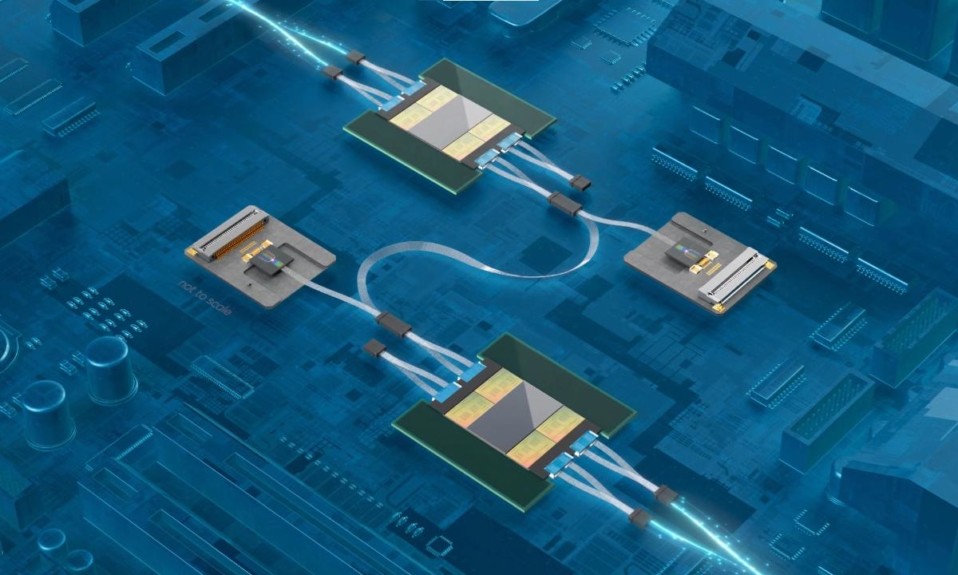

En un artículo divulgado en Data Base, los expertos se han hecho eco del “Informe epidémico disruptivo” anunciado por Ntirety sobre el estado de las bases de datos de Microsoft SQL Server donde, entre otros hallazgos claves, se determinó que el 90% de las instancias de SQL Server fallaron la revisión de recuperación de desastres y que el 88% de las instancias de SQL Server fallaron en la revisión de configuración.

40% de las instancias de SQL Server fallaron en la revisión de seguridad y el 39% de las instancias de SQL Server falló en la revisión de la copia de seguridad de la base de datos, según los resultados de la investigación sobre sistemas TI.

“Cuando se juntan estos hallazgos con el hecho de que la cantidad de datos que ahora se recopila se duplica anualmente, surge una imagen terrible. La tecnología necesaria para soportar estas bases de datos continúa creciendo y se vuelve más compleja. Esta imagen destaca un entorno empresarial en el que la administración solicita constantemente al personal de TI que haga más con menos recursos”.

No obstante, han referido otra imagen subyacente que se revela: la de una tormenta perfecta de eventos catastróficos. “Es sólo una cuestión de cuando la bomba de tiempo explota”.

Prevenir anticipándose

Corey y Sullivan han mencionado una serie de indicadores iniciales que aumentan la probabilidad de tener un problema de vulnerabilidad de datos dentro de las organizaciones. Revisarlos y hacer una evaluación honesta de la empresa sería el primer paso a seguir.

“¿Su equipo de administradores de bases de datos tiene poco personal? ¿Están continuamente trabajando largas horas? ¿La mayor parte del esfuerzo del equipo se dedica a apagar incendios? ¿Tienes problemas de rendimiento constantemente? Seamos realistas, si la respuesta es sí a estas preguntas, entonces su personal está haciendo grandes esfuerzos para hacer el trabajo”.

Es por ello que han invitado, principalmente, a no ejecutar una versión desactualizada de la base de datos por ser un riesgo de seguridad a la espera de que suceda. Y es que conocen varias compañías que, por ejemplo, ejecutan sistemas de producción en Oracle versión 8 (alrededor de 1997), cuando la última versión es Oracle12c.

“¿Está su personal constantemente atrasado en los ciclos de parcheo de la base de datos? La aplicación de parches a las bases de datos es fundamental para prevenir la corrupción de las bases de datos y las violaciones de seguridad. Si su organización no está actualizada sobre la aplicación de parches, usted está sufriendo daños colaterales en espera de ocurrir”.

También han exhortado a que se implementen soluciones formales de monitoreo y procedimientos de prueba en los sistemas TI, lo que incluye operaciones completas de gestión de cambios. Han dicho que las gerencias tampoco pueden tener expectativas de que la base de datos nunca bajará, teniendo una infraestructura física que no está a la altura de esos requisitos.

Las compañías, además, deben tener estrategias de copia de seguridad, probadas formalmente, que cumplan con los objetivos de punto y tiempo de recuperación de las organizaciones, así como procedimientos implementados que avisen cuando no se realiza una copia de seguridad de una base de datos. “Cualquiera que sobrevivió al huracán Sandy o Katrina entiende la importancia de un respaldo geográfico disperso”.

Evitar desastres TI

Otras de las recomendaciones de estos expertos es tener una validación de terceros que cumplan con HIPAA, PCI, SOX y MSPAlliance Cloud / Verify, así como identificar y difundir las bombas de tiempo antes de que el negocio se vea afectado. “Puede optar por tomar una acción preventiva o puede optar por convertirse en daño colateral”.

Asegurarse de un equipo DBA con personal adecuado y monitoreo proactivo, auditorías de terceros y controles de salud, mantener a todos los vendedores a altos estándares, aprovechar las tecnologías adecuadas en los lugares correctos, hacer simulacros de incendio hasta cerciorarse de probar las copias de seguridad, contar con un proceso adecuado de control de cambios y mantener actualizadas las bases de datos.

Esos también son consejos que podrían ayudar a las empresas a evitar el estallido de la bomba de tiempo en los sistemas TI, de acuerdo a Corey y Sullivan, ya que las probabilidades apuntan a tener una en cada organización. “¿Va a ser un daño colateral o va a difundir la bomba antes de que se haga el daño? La decisión es tuya”.