El equipo del Proyecto Eufonía, parte del programa AI for Social Good de Google, se encuentra utilizando la IA (Inteligencia Artificial) para mejorar la capacidad de las computadoras y así comprender diversos patrones del habla, como el habla deficiente.

Julie Cattiau, gerente de Producto en Google IA, ha informado que se han asociado con las organizaciones sin fines de lucro ALS Therapy Development Institute (ALS TDI) y ALS Residence Initiative (ALSRI) para grabar las voces de las personas que padecen de ELA (Esclerosis Lateral Amiotrófica o Amyotrophic Lateral Sclerosis, ALS).

Se trata de una condición neurodegenerativa que puede resultar en la incapacidad de hablar y moverse y, por ende, un trastorno que afecta la función de nervios y músculos.

Se cree que un poco más de cinco mil 600 habitantes de los Estados Unidos son diagnosticados con ELA anualmente, lo que equivaldría a 15 nuevos casos diariamente.

De acuerdo a la Asociación ALS, hasta 2011 se estimaba que alrededor de 30 mil estadounidenses padecían de la enfermedad en cualquier momento. La Asociación, ese mismo año, manejaba cifras de la base de datos de ALS CARE donde se revelaba que el 60% de las personas con ELA eran hombres y que el 93% de los pacientes eran de raza blanca.

“La mayoría de los aspectos de la vida involucran la comunicación con los demás y también ser comprendidos por esas personas. Muchos de nosotros damos por sentado este entendimiento, pero puedes imaginar la extrema dificultad y frustración que sentirías si la gente no pudiera entender fácilmente la forma en que hablas o te expresas”.

Cattiau, valiéndose de las numerosas estadísticas al respecto, ha insistido en que esa es la realidad para millones de personas que viven con trastornos del habla causados por afecciones neurológicas como apoplejía, ELA, esclerosis múltiple, lesiones cerebrales traumáticas y Parkinson.

Es por eso que el Proyecto Eufonía ha querido ayudar a resolver este problema colaborando estrechamente con estos grupos para conocer las necesidades de comunicación de las personas con ALS.

Al mismo tiempo, ha asegurado que trabajan en la optimización de los algoritmos basados en la Inteligencia Artificial, para que los teléfonos móviles y las computadoras puedan transcribir de manera más confiable las palabras habladas por personas con este tipo de dificultades para hablar.

La asociación del Proyecto Eufonía con el ALS TDI ha tenido buena receptividad y resultados, tal y como lo han recogido Fernando Vieira, director científico del ALS TDI, y Maeve McNally, director senior de Operaciones Clínicas del mismo instituto, en un artículo recientemente publicado.

Algoritmos de IA

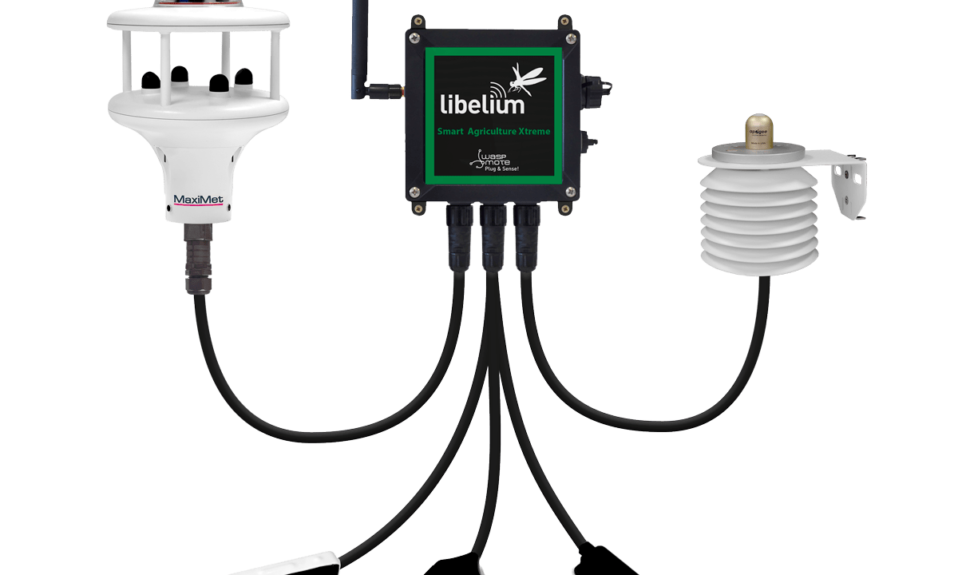

La gerente de Producto en Google IA ha explicado que, para hacer este proyecto una realidad, el software de Google convierte las muestras de voz grabadas en un espectrograma o una representación visual del sonido.

Luego, la computadora utiliza esos espectrogramas transcritos comunes para “entrenar” al sistema y que de esa manera reconozca mejor este tipo de habla que es menos común.

“Actualmente, nuestros algoritmos de Inteligencia Artificial tienen como objetivo dar cabida a las personas que hablan inglés y tienen discapacidades típicamente asociadas con ALS, pero creemos que nuestra investigación puede aplicarse a grupos más grandes de personas y a diferentes discapacidades del habla”.

Ha dicho que, además de mejorar el reconocimiento de voz, también se encuentran entrenando algoritmos personalizados de IA para detectar sonidos o gestos y luego realizan acciones como generar comandos hablados a Google Home o enviar mensajes de texto.

Esto, según ha considerado, podría ser particularmente útil para las personas con discapacidades graves y que no pueden hablar.

En su publicación, Julie Cattiau también ha incluido un video de Dimitri Kanevsky, un investigador del habla en Google que aprendió inglés después quedarse sordo cuando era niño en Rusia.

Dijo que Dimitri está utilizando Live Transcribe con un modelo personalizado entrenado de forma única para reconocer su voz. En el mismo video igualmente ha presentado colaboradores que padecen de ALS, como Steve Saling.

Este último ha sido diagnosticado con ALS desde hace 13 años y usa sonidos que no son del habla para activar dispositivos domésticos inteligentes, así como gestos faciales para animar durante un juego de deportes.

Comprometidos con el Proyecto Eufonía

La ejecutiva ha expresado que se sienten emocionados de ver a dónde les puede llevar el Proyecto Eufonía y, por eso, ha enfatizado que siguen necesitando ayuda.

“Estas mejoras en el reconocimiento de voz sólo son posibles si tenemos muchas muestras de voz para entrenar el sistema”.

Las personas que tengan dificultad para entender el habla, pueden llenar un breve formulario para ser voluntario y grabar un conjunto de frases. Se ha informado que cualquiera puede donar o ser voluntario con los socios de Google: ALS TDI y la Iniciativa de Residencia de ALS.

Y es que, cuantas más muestras de habla escuche el sistema, más potencial tendrán en la compañía para progresar y aplicar estas herramientas para apoyar mejor a todos, sin importar cómo se comuniquen.