“Tabula casi rasa” es el nombre del nuevo trabajo de Facebook AI (la unidad de Inteligencia Artificial de Facebook) que forma parte de sus esfuerzos continuos de para reducir la necesidad de supervisión en los sistemas de idiomas, incluidas las tareas de traducción automática.

Los resultados para este enfoque sugieren que, con suficientes aportes, los sistemas de Inteligencia Artificial pueden aprender muchas reglas lingüísticas desde cero.

La exploración también abre la puerta a futuras investigaciones sobre enfoques de aprendizaje de idiomas no supervisados, que requieren menos conocimientos previos que los sistemas actuales de PNL (Procesamiento de Lenguaje Natural).

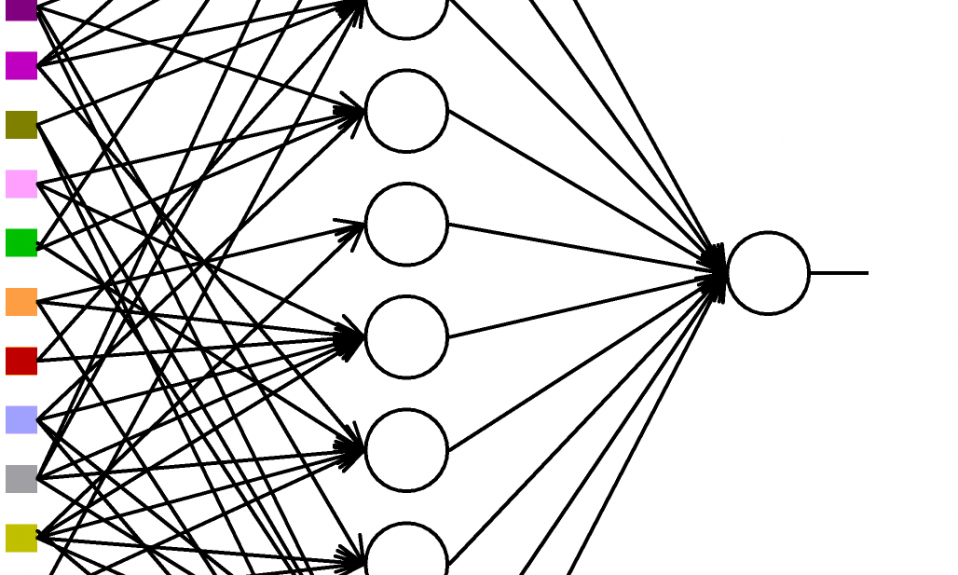

El estudio se basa en un nuevo enfoque del PNL que enseña los fundamentos lingüísticos de las redes neuronales, al capacitarlos utilizando información textual no segmentada sobre la interacción entre letras individuales, en lugar de palabras completas.

De acuerdo a una entrada de blog de Facebook AI, la mayoría de las redes neuronales recurrentes (RNN, por sus siglas en inglés) que forman la base de los sistemas de PNL están capacitadas en vocabularios de palabras conocidas.

Para capacitar a las RNN de una manera que se asemeje más a la forma en que los humanos aprenden los fundamentos del lenguaje, se han eliminado los límites de palabras de los conjuntos de datos de capacitación y se han entrenado a las redes a nivel de carácter (en lugar de palabra).

Entrenando redes neuronales recurrentes

Se ha explicado que un estudio multilingüe de esta tarea de modelado de lenguaje a nivel de carácter, no supervisado, utilizó conjuntos de datos de millones de palabras en inglés, alemán e italiano.

Ha mostrado además que estas RNN “Tabula casi rasa” desarrollan un impresionante espectro de conocimiento lingüístico, que incluye la segmentación de grupos de caracteres en palabras, distinguiendo nombres de verbos e incluso induciendo formas simples de significado de palabras.

Como se sabe, las redes neuronales recurrentes han alcanzado un rendimiento sorprendente en muchas tareas de procesamiento de lenguaje natural. “Esto ha renovado el interés en si estos dispositivos genéricos de procesamiento de secuencias están induciendo un conocimiento lingüístico genuino”.

Sin embargo, según la publicación, casi todos los estudios analíticos actuales inicializan los RNN con un vocabulario de palabras conocidas y les dan información de entrada durante el entrenamiento.

Es por eso que se ha presentado este estudio multilingüe del conocimiento lingüístico codificado en redes neuronales recurrentes, entrenadas como modelos de lenguaje a nivel de carácter, en datos de entrada con límites de palabras eliminados.

Los investigadores tienen claro que estas redes neuronales recurrentes se enfrentan a una tarea más difícil y más cognitivamente realista, tomando en cuenta que tienen que descubrir desde cero cualquier unidad lingüística útil basada en estadísticas de entrada.

Avanzando en RNN

Los resultados del estudio de Facebook AI muestran que, con “Tabula casi rasa”, los RNN pueden (en su mayoría) resolver tareas morfológicas, sintácticas y semánticas que presuponen intuitivamente el conocimiento a nivel de la palabra y que, de hecho, aprendieron (en cierta medida) a rastrear los límites de las palabras.

Desde el brazo de Inteligencia Artificial de Facebook también se ha indicado que la investigación abre la puerta a especulaciones sobre la necesidad de un léxico explícito y rígido de la palabra en el aprendizaje y uso del idioma.

“Este estudio proporcionó una verificación inicial necesaria de que los modelos sin palabras pueden explicar los fenómenos tradicionalmente considerados como basados en palabras”.

El trabajo futuro, según los autores y especialistas, “debería comprobar si dichos modelos también pueden explicar los patrones gramaticales que son más difíciles de capturar en formalismos basados en palabras, explorando tanto una gama tipológicamente más amplia de idiomas como un conjunto más amplio de pruebas gramaticales”.