MLIR, una infraestructura de compilador de Aprendizaje Automático (Machine Learning, ML) de código abierto, ha sido presentada a principios de este año. Hay que recordar que esta infraestructura aborda la complejidad causada por la creciente fragmentación de software y hardware, al tiempo que facilita la creación de aplicaciones de Inteligencia Artificial (IA).

También se ha explicado que MLIR ofrece una nueva infraestructura y una filosofía de diseño que permite que los modelos de Aprendizaje Automático se representen y ejecuten de manera consistente en cualquier tipo de hardware.

Chris Lattner, ingeniero distinguido de TensorFlow; y Tim Davis, gerente de Producto en TensorFlow, han informado que MLIR se encuentra contribuyendo con la Fundación LLVM, un ente sin fines de lucro. Esto, según lo planteado, permitirá una adopción aún más rápida de MLIR por parte de la industria en su conjunto.

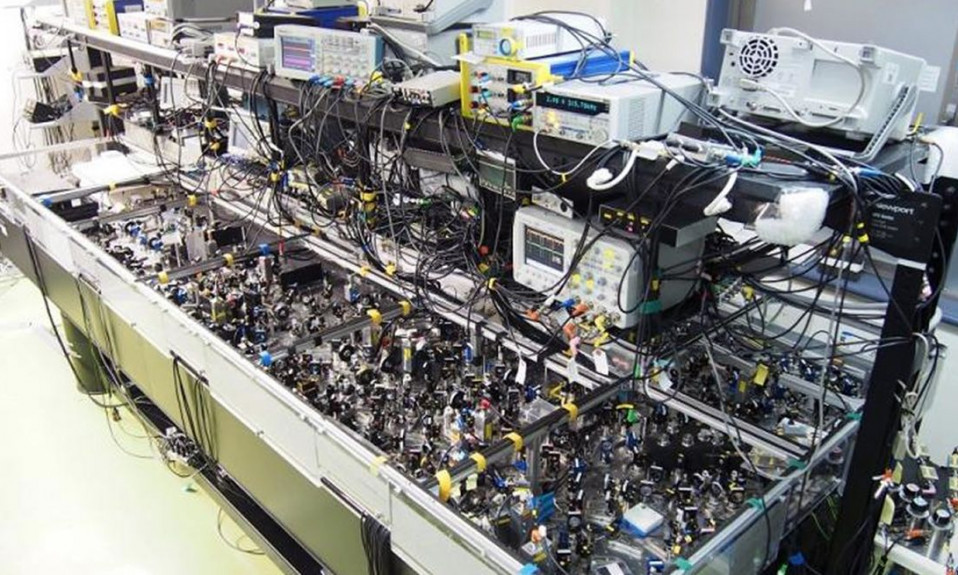

Y es que MLIR, en su afán por ser el nuevo estándar en infraestructura de Aprendizaje Automático, viene con un fuerte apoyo de socios globales de hardware y software.

En esta lista de socios se encuentran incluidos AMD, ARM, Cerebras, Graphcore, Habana, IBM, Intel, Mediatek, NVIDIA, Qualcomm Technologies, SambaNova Systems, Samsung, Xiaomi y Xilinx.

Lattner y Davis han precisado que estos asociados constituyen más del 95% del hardware acelerador de centros de datos del mundo, más de cuatro mil millones de teléfonos móviles e innumerables dispositivos IoT (Internet de las Cosas).

De acuerdo a lo explicado por los ejecutivos de TensorFlow mediante una entrada de blog, MLIR se está incorporando y utilizando en todos los esfuerzos de servidores y hardware móvil de Google.

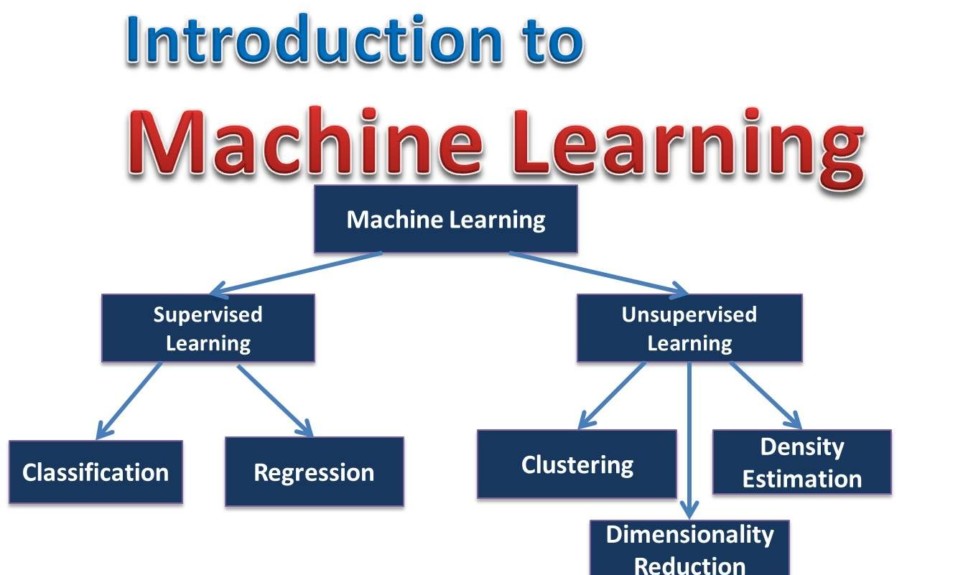

Infraestructura de Aprendizaje Automático

Los portavoces de TensorFlow han señalado que el Aprendizaje Automático ahora se ejecuta en todo, desde la infraestructura de la nube que contiene GPU (Unidad de Procesamiento Gráfico) y TPU (Unidad de Procesamiento Tensorial), y teléfonos móviles, hasta el hardware más pequeño como los microcontroladores que alimentan dispositivos inteligentes.

“La combinación de avances en hardware y marcos de software de código abierto como TensorFlow está haciendo posible todas las increíbles aplicaciones de Inteligencia Artificial que estamos viendo hoy en día”.

Ya se han podido conocer aplicaciones tan avanzadas como aquellas que tienen la capacidad de predecir el clima extremo, ayudar a las personas con impedimentos del habla a comunicarse mejor o ayudar a los agricultores a detectar plantas y enfermedades.

Pero la industria, con todo este progreso sucediendo tan rápidamente, está luchando para mantenerse al día con el hecho de que diferentes marcos de software de Aprendizaje Automático funcionen con un conjunto diverso y creciente de hardware.

Entonces, Lattner y Davis han puntualizado que el ecosistema de ML depende de muchas tecnologías diferentes, con distintos niveles de complejidad que a menudo no funcionan bien juntas. La carga de gestionar esta complejidad, según ellos, recae en investigadores, empresas y desarrolladores.

“Al disminuir el ritmo al que los nuevos productos orientados al Aprendizaje Automático pueden pasar de la investigación a la realidad, esta complejidad finalmente afecta nuestra capacidad para resolver problemas desafiantes del mundo real”.

MLIR, IA en rápido avance

A juicio de Lattner y Davis, el Aprendizaje Automático ha recorrido un largo camino, pero aún consideran que es “increíblemente temprano”. Para ellos, la Inteligencia Artificial avanzará más rápido con la nueva infraestructura MLIR.

Ambos esperan que MLIR pueda permitir entrenar e implementar modelos a mayor escala por parte de los investigadores, con más consistencia, velocidad y simplicidad en diferentes hardware.

Estas innovaciones, según la publicación de blog, pueden llegar rápidamente a los productos que usa la gente todos los días y funcionar sin problemas en todos los dispositivos que tengan las personas, lo que finalmente hace que la IA sea más útil y aporte más ventajas para todos en el planeta.