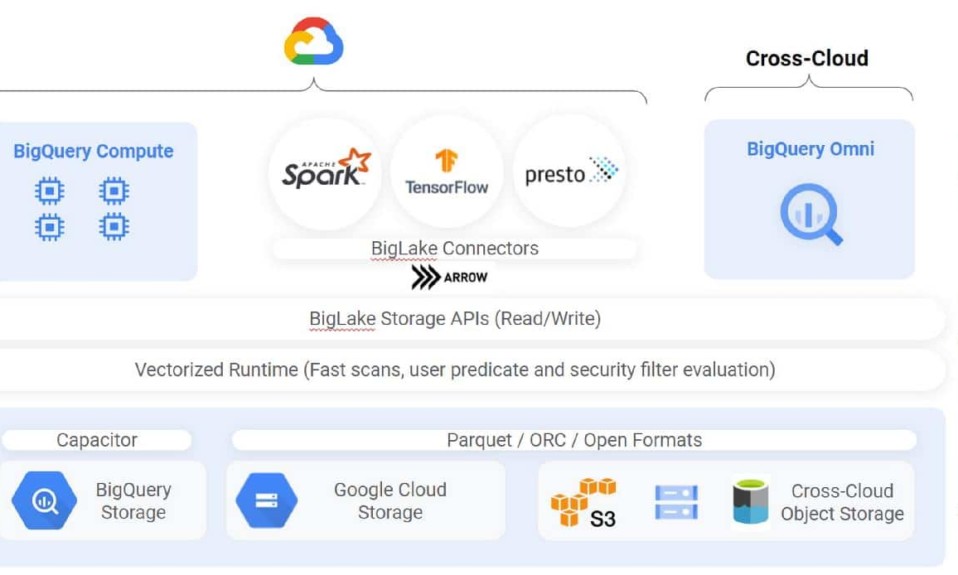

BigLake es un nuevo motor de almacenamiento que permite unificar almacenes y lagos de datos. La herramienta de Google Cloud brinda a los equipos el poder de analizar datos sin preocuparse por el formato o sistema de almacenamiento subyacente.

Justin Levandoski y Gaurav Saxena, ingeniero de Software y gerente de Producto en Google Cloud, respectivamente, han informado que también elimina la necesidad de duplicar o mover datos, lo que reduce los costos y las ineficiencias.

“A medida que los datos de una organización se vuelven más complejos y proliferan en entornos de datos dispares, surgen silos, lo que crea un mayor riesgo y costo, especialmente cuando es necesario mover esos datos”.

Con BigLake se obtienen controles detallados de acceso, junto a la aceleración del rendimiento en BigQuery y lagos de datos de múltiples nubes en AWS (Amazon Web Services) y Azure (la nube de Microsoft).

Además, hace que los datos sean accesibles de manera uniforme en Google Cloud y motores de código abierto con seguridad constante.

“Extienda BigQuery a lagos de datos multinube y formatos abiertos como Parquet y ORC con controles de seguridad detallados, sin necesidad de configurar una nueva infraestructura”.

BigLake también permite conservar una única copia de los datos y aplicar controles de acceso coherentes en los motores de análisis que se elijan, incluidos Google Cloud y tecnologías de código abierto como Spark, Presto, Trino y Tensorflow.

Acelerando la analítica

Levandoski y Saxena indicaron que Bol.com ha sido uno de los primeros clientes que ha usado BigLake, acelerando sus resultados analíticos mientras mantiene sus costos bajos.

Martin Cekodhima, ingeniero de Software en la empresa de comercio electrónico, ha confirmado el rápido crecimiento en los datos y dijo que la solución de Google Cloud les ha permitido desbloquear el valor de esos lagos de datos.

Esto ha sido posible al habilitar el control de acceso en sus vistas mientras proporciona una interfaz unificada a sus usuarios y mantiene bajos los costos de almacenamiento de datos.

“Esto, a su vez, permite un análisis más rápido de nuestros conjuntos de datos por parte de nuestros usuarios”.

También se ha afirmado que los clientes de BigQuery, al crear tablas de BigLake, pueden ampliar sus cargas de trabajo a lagos de datos integrados en Google Cloud Storage (GCS), Amazon S3 y Azure Data Lake Storage Gen 2.

En conjunto, todas sus capacidades permiten ejecutar múltiples tiempos de ejecución analíticos sobre lagos y almacenes que abarcan datos de manera gobernada.

“Esto rompe los silos de datos y reduce significativamente la administración de la infraestructura, lo que lo ayuda a avanzar en su pila de análisis y desbloquear nuevos casos de uso”, agregaron los ejecutivos.